植入AI 解碼大腦信號 啞巴 有機會說話了

(華盛頓29日綜合電)美國加州大學舊金山分校(UCSF)研究團隊,日前進行一項實驗,即在受試者的大腦植入電極,運用實驗性的腦波紀錄器,並結合人工智慧(AI)、機器學習與語音合成技術,將他們的大腦訊號解碼,轉換為合成語音。

據悉,相關技術未來有望令咽喉癌、腦部受傷、帕金森氏症等疾病而後天變啞的人士「表達心聲」。

據英國科學期刊於上周三的報導,該研究團隊針對5名男女進行試驗,他們都能正常講話,成為受試者是因患有嚴重癲癇,腦部已被植入電極來勘測癲癇發作源頭,準備日後手術移除。這項研究分為三步驟,首先,研究人員要求他們大聲閱讀數十個句子,以電極紀錄他們的大腦運動皮質發出的神經脈衝訊號,最後紀錄到大腦皮質用來控制嘴唇、下顎、喉嚨、舌頭等約百條肌肉動作的相關腦部訊號。

接著,研究人員設計出神經系統網路,將這些訊號轉譯為肌肉活動,接著再轉換為合成語音,這個過程花了1年。

最後,由電腦把訊號合成句子,再由志願者識別這些字詞。研究發現,這些合成語音的精準度約達70%,語速約每分鐘150字,為正常說話速度。過去醫界曾以追蹤無法言語者的眼球、臉部肌肉活動的裝置,讓他們費力逐個拼寫生字,但此種方式速度很慢,通常每分鐘少於10個字。

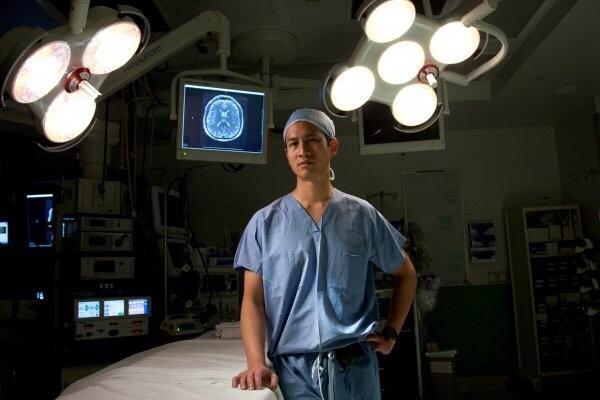

這項研究形同辨別受試者的聲道活動,為他們創造出「虛擬聲道」。相關研究主筆、UCSF華裔教授張復倫指出,他們使用的方法是基於」虛擬人體聲道」的概念,大腦會把思想轉變成聲道運動,「我們就是要解碼這個運動」。據悉,張復倫來自台灣移民家庭,出生在內華達州。

這項研究是首例,展現可以依據個人腦部活動,產生完整的口語句子。華爾街日報引述專家看法指出,這項技術要落實到臨床使用,可能還需十年或更久。研究共同作者夏提爾強調,研究人員正致力使合成語言更清晰、較不含?,未來若改進所使用的演演算法應可取得更好結果,下一步則打算對無法說話的人士測試這項科技。研究團隊也表示,這項科技依賴控制嘴唇、舌頭、喉頭及下顎的大腦部位正確運作,因此部份中風患者可能無法受益。

張復倫是相關研究的主筆。

文:綜合報導

圖:網際網路